大数据时代的高速发展推动互联网、大数据、云计算、人工智能、区块链等技术日益创新,金融、互联网、运营商、政府等数据密集型行业的数据存储量呈现爆发性增长的趋势,如何从海量数据中帮助企业更好管理和挖掘业务数据价值,满足企业业务快速发展的需求,成为大数据数仓应用的重要方向。

大数据数仓通常采用分布式计算技术,利用大数据天然的扩展性来完成海量数据的存放,同时把SQL转换成针对大数据计算引擎的任务,实现数据分析,如Hadoop、Spark等作为存储和计算引擎,使用工具或编程语言设计处理逻辑,实现对不同数据源的汇聚、清洗、计算和分析。除此之外,大数据数仓还具有面向海量数据、可高效查询和分析、具备数据安全性以及灵活性等特点。

在国内,本地部署模式的数据仓库仍是目前政府、金融、能源以及大型企业的首选。固态硬盘凭借其高吞吐量、低时延等特征逐渐成为大数据时代下数据存储的重要载体,是当前本地部署的数据仓库产品重要搭载硬件。

为更好应对数据密集型行业对高性能、高可靠存储的需求,忆联特联合国内大数据仓储的佼佼者——南大通用(下称:GBase)共同探索大数据时代下数字化转型存储新方案。

南大通用大规模分布式并行数据库集群系统(简称GBase 8a MPP Cluster),是在GBase 8a系列存储数据库基础上开发的一款Shared Nothing 架构的分布式并行数据库集群,具备高性能、高可用、高扩展等特性,可为各种规模数据管理提供高性价比的通用计算平台,广泛用于支撑各类数据仓库系统、BI系统和决策支持系统。

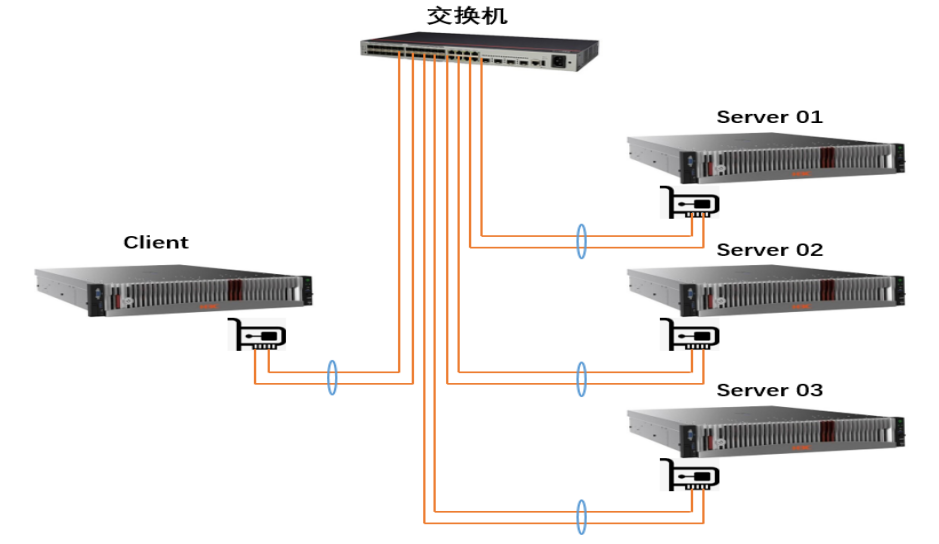

图1:GBase 8a MPP Cluster技术架构图

GBase 8a MPP Cluster采用MPP+Shared Nothing的分布式联邦架构,节点间通过 TCP/IP网络进行通信,每个节点采用本地磁盘来存储数据。GBase 8a MPP Cluster系统中的每一个节点都是相对独立的、自给的,整个系统具有非常强的扩展性,可从几个节点扩展到上百节点,满足业务规模增长的要求。

1 验证环境

1.1 本次验证硬件配置

|

类型 |

型号 |

硬件配置 |

备注 |

|

服务器 |

2U2路(X86) |

CPU:Intel® Xeon® Gold 6330 CPU@2.00GHz*2 |

3台 |

|

内存:8*32GB |

|||

|

存储控制器:支持RAID 5(数据盘) |

|||

|

网卡:1*2端口10GE以太网卡 |

|||

|

硬盘 |

忆联SSD |

系统盘:2*480GB SATA SSD 数据盘:6*3.84TB SAS SSD(UM511a) |

|

|

交换机 |

10GE 交换机 |

48端口10GE交换机 |

/ |

1.2 本次验证软件配置

|

类型 |

型号 |

版本 |

备注 |

|

操作系统 |

redhat(x86) |

7.9 |

/ |

|

GBase版本 |

GBase 8a |

GBase8a_MPP_Cluster-License-9.5.3.14 |

/ |

|

客户端 |

gccli |

9.5.3.14 |

/ |

|

数据库压测 |

TPC-DS |

3.2.0rc1 |

开源 |

|

数据库压测 |

TPC-H |

3.0.0 |

开源 |

|

网络监控 |

SAR |

10.1.5 |

OS自带 |

|

IOSTAT |

盘侧IO统计 |

10.0.0 |

/ |

|

MPSTAT |

CPU利用 |

10.1.5 |

/ |

1.3 本次验证组网规划

图2:本次GBase 8a MPP组网规划架构图

2 验证方法

步骤1:将6块SAS UM511a配置Raid5。

步骤2:创建数据库和表

Ø 使用TPC-H工具评估数据库分析处理能力,需要提前创建数据库和TPC-H内置的8张表;

Ø 使用TPC-DS工具评估数据库分析处理能力,提前创建数据库和TPC-DS内置的25张表。

步骤3:参数调优

根据GBase建议进行相关参数调优。

步骤4:数据生成

Ø TCH-H通过dbgen工具可以通过设置参数生成所需的测试数据,命令参数为/dbgen -C 10 -S 1 -s 3000 –vf;

Ø TPC-DS通过dsdgen工具可以通过设置参数生成所需的测试数据,命令参数为./dsdgen -scale 3000 -dir testdata -force -parallel 10 -child 1。

步骤5:数据加载

Ø 数据导入时,在GBASE集群本地节点搭建FTP服务器,通过FTP加载数据。当一个表包含多个数据文件时,将单表的多个数据文件集成一个导入语句中,以单表为粒度分别加载测试数据至8张数据库表中。

步骤6:SQL执行

Ø 独立的客户端,通过业务平面网络与GBase集群通信,使用gccli工具执行TPC-H 22个SQL用例,参考命令为/home/GBase/gccli_install/gcluster/server/bin/gccli -h 10.28.100.38 -uroot -Dtpch -vvv < query_1.sql。

3 验证结果

本次在GBase 8a MPP场景下验证结果如下:

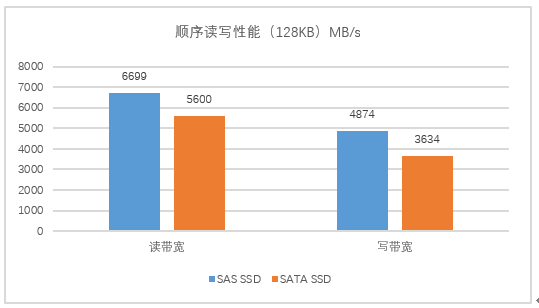

3.1忆联SAS SSD在Raid逻辑卷带宽性能测试下的表现

图3:忆联SAS盘在Raid逻辑卷带宽性能测试下的表现

在本次测试中,将6个SAS SSD配置Raid5,12块SATA配置Raid50,在Server主机使用FIO测试工具进行128KB顺序读写带宽性能压测。从图3结果表现可知,SAS SSD读写带宽更优,读带宽比SATA有19.6% 左右提升,写带宽提升34% 左右,展现了SAS SSD在Raid逻辑卷带宽下的绝对优势。

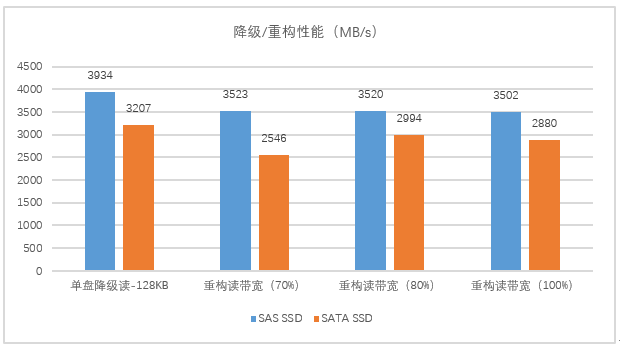

3.2忆联SAS SSD在单盘故障降级&重构读性能下的表现

图4:忆联SAS SSD在单盘故障降级&重构读性能下的表现

单盘降级读性能是指RAID组在单盘故障或拔出情况下的RAID组逻辑卷读业务性能,重构性能是指但盘故障后,RAID同时进行热备盘数据重构和业务下发时的业务侧性能。本次通过将6块忆联SAS SSD配置Raid5后,在一块SSD故障条件下进行测试。

如图4所示,不管是在单盘降级读性能还是在重构读带宽条件下,SAS盘的表现都优于SATA,单盘降级读性能优于SATA 22.7% 左右,重构读带宽性能上比SATA最大有38.4% 左右的提升。

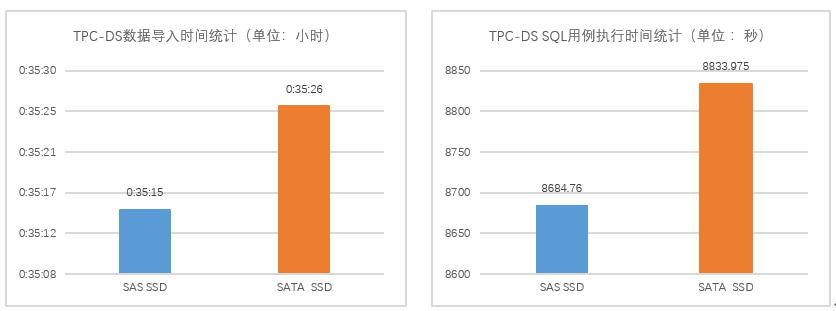

3.3忆联SAS SSD在TPC-DS场景下的表现

图5:TPC-DS场景下忆联SAS SSD的表现

TPC-DS测试是通过FTP协议加载数据到GBase数据库表。从图5可见,在相同物理硬件环境下,SAS SSD不管是在数据导入还是在SQL用例执行时间上所用时间都略低于SATA SSD,具备一定时间优势。

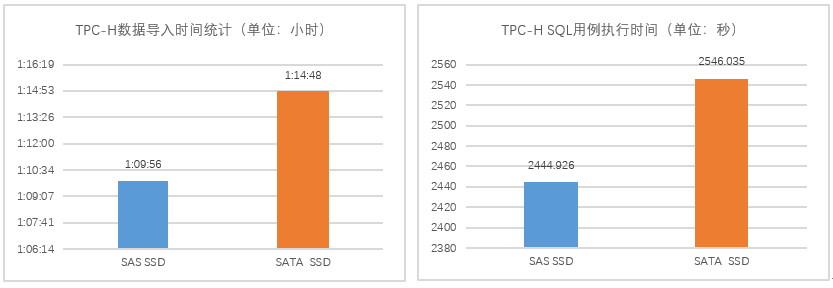

3.4 忆联SAS SSD在TCP-H场景下的表现

图6: TPC-H场景下忆联SAS SSD的表现

TPC-H测试是通过FTP协议加载数据到GBase数据库表。图6展现了SAS SSD以及SATA SSD在TPC-H测试下的表现,其中SAS SSD总用时略优于SATA SSD ,数据导入时间优于SATA约6% ,对SQL用例执行时间上相比SATA SSD降低了3% 左右。

本次验证可充分体现忆联SAS SSD 在GBase 8a MPP场景下的性能优势,SAS SSD可有效支持业务高效开展,具备单盘带宽更高,盘故障重构、降级性能更优等优势,不仅可以帮助企业节约硬件采购成本,也可解决海量数据下的大数据存储和计算问题,高效处理海量结构化数据。

忆联深耕固态硬盘领域多年,已发布多款高性能、高可靠产品,具备应对复杂的业务环境和数据库挑战的能力,可满足行业用户海量数据处理需求。忆联将持续联合GBase共同打造数字化转型背景下的存储新方案。